Testy A/B słusznie uchodzą za jedno z najskuteczniejszych narzędzi, które pozwalają podejmować decyzje na podstawie danych, a nie przeczucia. W teorii brzmi to prosto: pokazujesz użytkownikom dwie wersje strony i sprawdzasz, która działa lepiej. W praktyce jednak między „zróbmy test” a „wyciągnęliśmy wiarygodne wnioski” rozciąga się spory dystans.

Źle zaplanowany lub zbyt pochopnie zinterpretowany test może nie tylko nie przynieść oczekiwanej wartości, ale wręcz zaszkodzić utwierdzając zespół w błędnych przekonaniach. Zamiast dostarczać klarownych insightów, generuje chaos, fałszywe zwycięstwa i decyzje, które prowadzą w złym kierunku.

Testy A/B mają ogromny potencjał biznesowy, ale tylko wtedy, gdy są prowadzone świadomie: z jasną hipotezą, poprawnym pomiarem i umiejętnością oceny wyników.

Oto pięć najczęstszych błędów, które odbierają testom A/B ich biznesową wartość oraz wskazówki, jak ich unikać.

Testy bez hipotezy i jasnego celu

Wiele firm uruchamia eksperymenty „bo trzeba coś testować”. Efekt? Zmiana koloru przycisku albo przerzucenie banera w inne miejsce – bez powiązania z realnym problemem użytkownika i bez odniesienia do celów biznesowych. Takie testy rzadko przynoszą wartość, a częściej marnują ruch i czas.

Dobry test zaczyna się od zrozumienia, dlaczego coś nie działa tak, jak powinno. Potrzebna jest obserwacja: analiza danych, heatmap, wyników badań czy nagrań sesji. Na tej podstawie formułujesz hipotezę – konkretną, mierzalną i logiczną. Jeśli wiesz, co chcesz sprawdzić i po czym poznasz sukces, test staje się elementem procesu uczenia się o użytkowniku, a nie losową zmianą w interfejsie.

Rada: zawsze zaczynaj od obserwacji danych i „wąskich gardeł” i na tej podstawie sformułuj hipotezę. Zrozum, gdzie użytkownicy odpadają i dlaczego, a dopiero potem projektuj wariant. Hipoteza typu „skrót formularza zwiększy liczbę zamówień” czy „lepsze wyróżnienie CTA poprawi klikalność” nadaje eksperymentowi sens i pozwala realnie ocenić wpływ zmian. Dzięki temu test staje się odpowiedzią na realny problem, a nie losową zmianą na stronie.

Opisz nam swoje wyzwanie,

i porozmawiajmy.

Zbyt krótki czas trwania testu

Kiedy pierwszego dnia wykres „świeci się na zielono”, pojawia się pokusa szybkiego ogłoszenia sukcesu. Ale mała próba i krótki czas trwania mogą prowadzić do fałszywych wniosków. Wyniki testów A/B często mocno się zmieniają w pierwszych dniach, zanim osiągną stabilność. To efekt zbyt małej próby i przypadkowego rozkładu użytkowników. W praktyce może się okazać, że po dwóch tygodniach „wygrywająca” wersja przestaje różnić się od oryginału, a po miesiącu wynik całkowicie się odwraca. Zbyt krótki test nie daje szansy na uwzględnienie cyklicznych wzorców ruchu, weekendów, kampanii czy sezonowości, które potrafią mocno wpływać na zachowania klientów.

Rada: zaplanuj minimalny czas trwania testu, najlepiej do momentu osiągnięcia zakładanej próby i istotności statystycznej. Ustal z góry kryteria stopu i trzymaj się planu. Nie podejmuj decyzji „na oko”. Lepiej poczekać kilka dni dłużej i mieć pewność, że wynik jest wiarygodny, niż wdrożyć zmianę, która tylko przypadkiem wyglądała na lepszą.

Ignorowanie jakości danych

Nawet najlepsza hipoteza nie ma sensu, jeśli dane, na których ją opierasz, są błędne. Test może wyglądać profesjonalnie, raport generuje wykresy i procenty, ale jeśli pod spodem coś jest źle zmierzone cały wysiłek idzie na marne. To jeden z najczęstszych, a jednocześnie najbardziej kosztownych błędów w testowaniu.

Problemy pojawiają się na wielu poziomach: nieprawidłowo otagowane eventy, błędne przypisanie użytkowników do wariantów, rozbieżności między przeglądarkami, czy modyfikacje kodu w trakcie trwania testu.

Rada: zanim uruchomisz test, poświęć czas na porządny QA. Sprawdź poprawność śledzenia zdarzeń, równy podział użytkowników między wariantami oraz działanie testu na różnych urządzeniach i przeglądarkach. Dobrym zwyczajem jest też krótki test A/A, czyli porównanie dwóch identycznych wersji, który pozwala upewnić się, że dane zbierają się prawidłowo. Lepiej wykryć błąd przed startem, niż po tygodniach działania testu odkryć, że cały test opierał się na złych danych.

Zbyt wiele zmian naraz

Chęć przyspieszenia optymalizacji często prowadzi do testów, w których wprowadzanych jest kilka zmian jednocześnie: nowe copy, zdjęcia, układ, kolory. W efekcie trudno później ustalić, która z tych zmian faktycznie wpłynęła na wynik – test pokazuje, że „coś zadziałało”, ale nie wiadomo co. To ogranicza możliwość uczenia się na przyszłość i utrudnia powtarzanie skutecznych rozwiązań.

Jednocześnie w praktyce, przy niskim ruchu, testowanie pojedynczych elementów często jest po prostu niemożliwe. Mały test ciągnięty miesiącami nie ma wartości, bo w tym czasie zmieniają się źródła ruchu, sezonowość, a nawet zachowania użytkowników. Wynik przestaje być wiarygodny. W takiej sytuacji lepiej przeprowadzić test większego pakietu zmian i potraktować go jako sprawdzenie kierunku, a nie szczegółów.

Rada: dostosuj skalę testu do możliwości serwisu. Jeśli masz wystarczający ruch, skupiaj się na pojedynczych hipotezach – wtedy naprawdę wiesz, co działa. Ale jeśli liczba użytkowników jest mocno ograniczona, możesz być w sytuacji, gdzie nie masz możliwości sprawdzać drobnych zmian. Wówczas lepiej potraktować eksperyment szerzej, jako sprawdzenie całego kierunku: nowego layoutu, uproszczonego procesu czy innego sposobu prezentacji oferty. Taki test nie pokaże, który element dokładnie zadziałał, ale pozwoli szybko ocenić, czy zmiana w ogóle idzie w dobrą stronę.

Brak systematycznego procesu

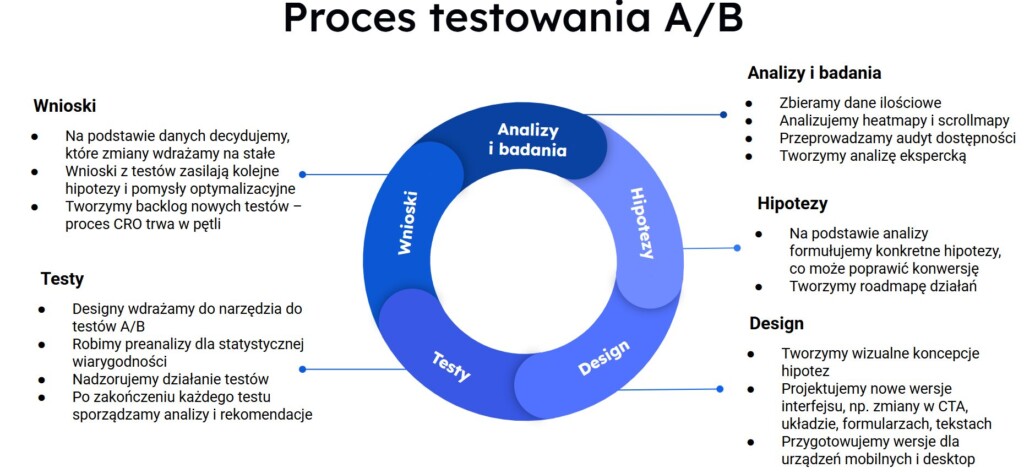

Test zakończony? Świetnie. Ale jeśli po wdrożeniu wnioski lądują w zapomnianym folderze, a lista pomysłów do dalszego testowania nie jest aktualizowana, cały wysiłek szybko traci wartość. Zespół wykonuje kolejne eksperymenty, ale niewiele z nich wynika – brak ciągłości sprawia, że organizacja nie uczy się na własnych doświadczeniach.

Bez uporządkowanego procesu testy łatwo zamieniają się w serię pojedynczych inicjatyw. Zmieniają się ludzie, narzędzia, priorytety i po kilku miesiącach nikt nie pamięta, dlaczego dana zmiana została wprowadzona ani jaki miała efekt. Wtedy zaczyna się powtarzanie tych samych pomysłów, analizowanie tych samych błędów i marnowanie ruchu na rzeczy, które ktoś już kiedyś sprawdził.

Rada: dokumentuj każdy test w prosty, powtarzalny sposób: cel, hipoteza, czas trwania, wynik, kluczowe obserwacje i rekomendacje. Po zakończeniu jednego eksperymentu od razu zdefiniuj, jaki będzie następny krok – co warto sprawdzić dalej, jak można pogłębić wynik, co przetestować w kolejnej iteracji. Z biegiem czasu powstaje z tego proces uczenia się oparty na danych, w którym każdy test wnosi coś nowego i wzmacnia poprzednie.

Podsumowanie

Testy A/B to nie loteria, tylko proces uczenia się o użytkownikach i biznesie. Jeśli unikasz typowych błędów każdy kolejny eksperyment staje się inwestycją w wiedzę, która procentuje.

Nawet „przegrany” test to krok naprzód, bo pokazuje, czego nie robić i gdzie szukać następnych szans. A wygrane? To nie tylko wyższa konwersja, ale i większa pewność, że Twoje decyzje mają twarde uzasadnienie w danych.