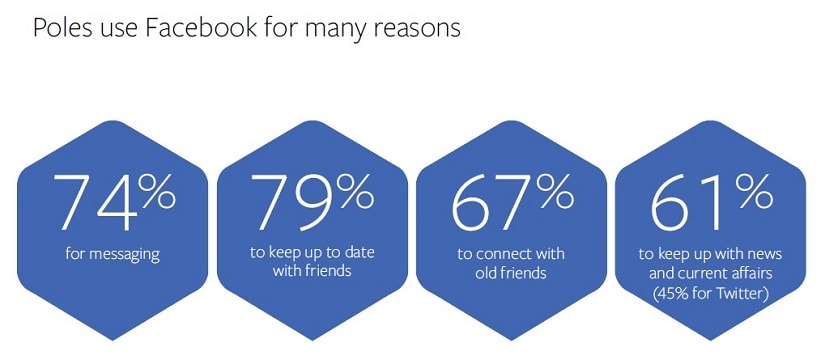

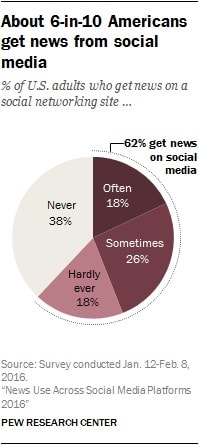

Social media coraz częściej traktowane są jak źródło informacji. Według GfK 61% Polaków szuka wiadomości na Facebooku, a 45% na Twitterze. Wielu robi to, nie mając świadomości, że z każdym kolejnym kliknięciem zamyka się w bańce informacyjnej. Podobne mechanizmy funkcjonują w wyszukiwarkach. Czy może to oznaczać, że internet wcale nie daje nam szerokiego dostępu do informacji?

Bańka informacyjna – co to takiego?

Algorytmy – to one odpowiadają za selekcję informacji dla konkretnego użytkownika. Wyszukiwarki i media społecznościowe śledzą naszą aktywność, wykorzystują podawane dane, by finalnie przedstawić najtrafniejsze treści – wybrane przez algorytm z założeniem, że trafią w gusta odbiorcy. Z punktu widzenia konsumenta może być to wygodne i pożądane. Jednak użytkownik nie jest tylko konsumentem, ale również osobą z własnymi przekonaniami, wartościami – zmiennymi w czasie.

Sytuacja, w której docierają do nas jedynie informacje zbieżne z poglądami i zachowaniami sprawia, że nabieramy nadmiernego przeświadczenia o słuszności swoich racji, tracimy świadomość istnienia innych przekonań, a tym samym radykalizujemy swój światopogląd. Funkcjonujemy zamknięci w bańce informacyjnej, otoczeni wiadomościami odfiltrowanymi specjalnie dla nas.

Elie Pariser, twórca terminu filter bubble (bańka filtrująca), zwrócił uwagę na dopasowywanie wyników wyszukiwania przez Google do preferencji użytkownika. W książce The Filter Bubble: What the Internet Is Hiding from You wskazał, że wyszukiwarka zbiera informacje o użytkownikach, by na podstawie indywidualnych preferencji, dopasować jak najlepszy rezultat do zapytania. Dlatego u dwóch różnych osób wyniki wyszukiwania dla tych samych fraz mogą znacząco się różnić. Pariser, podczas jednej ze swoich prelekcji, przywołał przykład znajomych, których poprosił o wpisanie w wyszukiwarkę Google frazy Egipt. Okazało się, że kiedy jeden z nich otrzymał wyniki poruszające temat kryzysu i strajków, wyniki drugiego miały głównie charakter turystyczny.

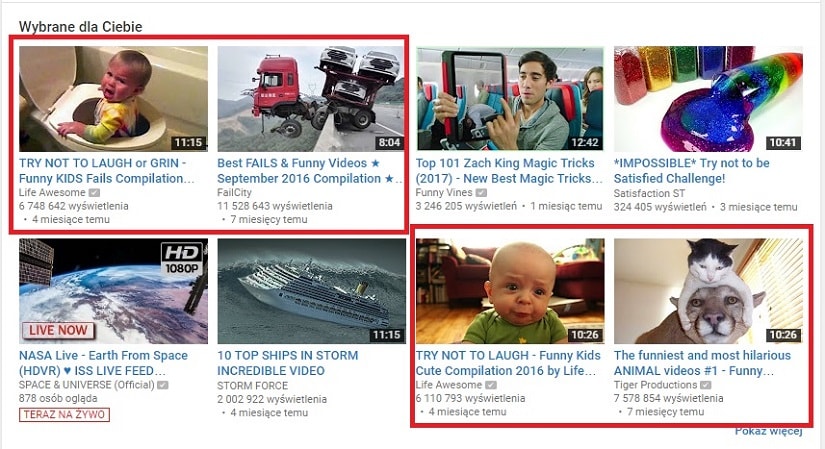

Funkcjonalność wyszukiwarki może być pomocna – Google, korzystając z algorytmu, dopasowało wynik do uzyskanych wcześniej informacji o użytkowniku: jego zainteresowaniach, lokalizacji itp. Pariser podnosi jednak, że nie w każdym przypadku personalizację można oceniać tak samo pozytywnie. O co chodzi z wygraną Trumpa, czyli o social media bubble Zjawisko bańki informacyjnej widoczne jest jeszcze wyraźniej w social media. Z łatwością można zauważyć, że algorytm dobiera wyświetlane posty do upodobań użytkowników. Oglądając kompilację zabawnych sytuacji na YouTube’ie, należy spodziewać się, że kolejnymi proponowanymi filmami będą… kompilacje zabawnych sytuacji.

O co chodzi z wygraną Trumpa, czyli o social media bubble

Zjawisko bańki informacyjnej widoczne jest jeszcze wyraźniej w social media. Z łatwością można zauważyć, że algorytm dobiera wyświetlane posty do upodobań użytkowników. Oglądając kompilację zabawnych sytuacji na YouTube’ie, należy spodziewać się, że kolejnymi proponowanymi filmami będą… kompilacje zabawnych sytuacji.

Mechanizm działa też na Facebooku. Po polajkowaniu kilku postów na jednym z fanpage’y, w newsfeedzie wyświetlą się zbieżne tematycznie, nierzadko też pochodzące z tej samej strony. Mark Zuckerberg, zapytany przez dziennikarza o istotę newsfeedu, powiedział:

A squirrel dying in front of your house may be more relevant to your interests right now than people dying in Africa.

Wiewiórka umierająca przed twoim domem może bardziej odpowiadać twoim zainteresowaniom w danym momencie niż ludzie umierający w Afryce.

Informacje dobierane są specjalnie dla nas. Odpowiada za to algorytm EdgeRank. Są w nim stosowane trzy zmienne – czas (ile go upłynęło od publikacji), waga posta (jak dużo użytkowników zareagowało na post i w jaki sposób) i intensywność wcześniejszych interakcji. Właśnie ostatnia zmienna jest najbardziej zależna od nas – im więcej będziemy mieć kontaktu z fanpage’em (lajkowanie, wysyłanie komentarzy, udostępnianie treści), tym bardziej algorytm uważa, że chcemy widzieć treści publikowane przez tę stronę.

To właśnie za sprawą bańki social media po wyborach prezydenckich w USA w 2016 roku i wygranej Trumpa pojawiło się wielkie poruszenie. Przez personalizację treści oponenci nie byli w stanie zauważyć, że Trump też ma swoich sympatyków! Że to, co krytykowane w wyświetlanych im informacjach (a dopasowane na podstawie aktywności i zgodne z poglądami), w innej części internetu spotykało się z pozytywnym odzewem.

Naturalne jest, że lubimy otaczać się ludźmi, z którymi zgadzamy się i mamy wspólne zainteresowania – portale społecznościowe nie są tu wyjątkiem. Dbając o satysfakcję użytkowników, social media dostarczają takich treści, które w teorii trafiają w gusta. Jednocześnie blokują dostęp do informacji sprzecznych z zainteresowaniami, poglądami. Dlatego udostępnienia znajomych często pokrywają się z tym, co sami myślimy. Jeśli mamy poglądy prawicowe, Facebook wyświetli nam posty prawicy; jeśli lewicowe – udostępniane wiadomości będą sprzyjać lewicy. Słuchając przeważnie rocka, zobaczymy udostępnienia muzyki rockowej itp.

Dodatkowo nasz mózg wcale nie pomaga w zapobieganiu tej sytuacji, a wręcz jej przyklaskuje. Jednym ze zjawisk, które wspiera podobne działania jest błąd konfirmacji. To tendencja do preferowania treści, potwierdzających nasze oczekiwania, przy jednoczesnym odrzuceniu i dyskredytowaniu tych treści, które im nie odpowiadają. Chronimy swoje racje za wszelką cenę, choćby okazywały się błędne.

Co więcej, występuje też presja społeczna – nawet jeśli któryś ze znajomych chciałby choćby polubić treść sprzeczną (albo po prostu rozbieżną) z wartościami społeczności, w której się obraca, ma świadomość, że jego aktywność także może zostać zauważona. Tym bardziej, że niektórzy mają zwyczaj usuwania ze znajomych osób, z którymi się nie zgadzają. W ten sposób bańka social media jeszcze bardziej się zacieśnia, doprowadzając do powstania tzw. echo chamber – sytuacji, w której informacje zgodne z przekonaniami danej społeczności są wzmocnione przez komunikację i powtarzane w jej zamkniętych ramach.

Jak uciec z bańki

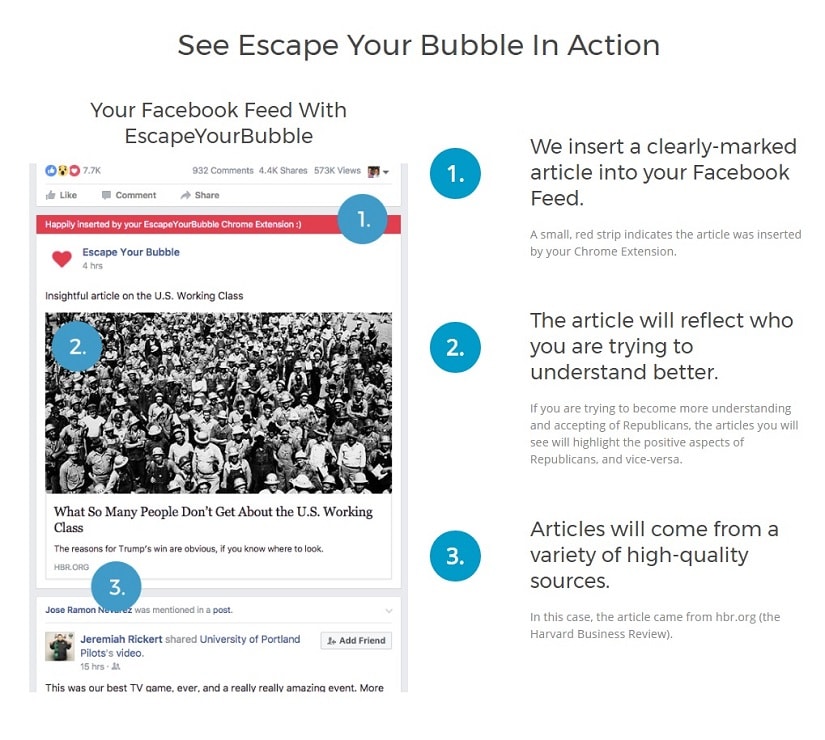

Funkcjonowanie w bańce informacyjnej może ograniczać światopoglądowo. Jak z nim walczyć? W Stanach Zjednoczonych, gdzie świadomość filter bubble jest bardzo duża, użytkownicy mają do dyspozycji aplikacje i rozszerzenia przeglądarek, które wprowadzają różnorodność. Pop Your Bubble to aplikacja na Facebooku, która na podstawie analizy profilu, sugeruje użytkowników o odmiennej perspektywie. FlipFeed – rozszerzenie przeglądarki Chrome – pozwala na zobaczenie na Twitterze newsfeedu osoby o przeciwnych poglądach, a Escape Your Bubble – także rozszerzenie przeglądarki Chrome – wstawia do facebookowego newsfeedu proponowane artykuły, sprzyjające wybranej stronie politycznej.

Narzędzia nie są dostępne w Polsce, ale wraz z rosnącą świadomością istnienia problemu niewykluczonym jest, że ktoś podejmie się stworzenia aplikacji działającej w naszym kraju. Na razie jednak warto dbać o różnorodność treści na własną rękę:

- Dobrym pomysłem jest urozmaicenie swoich źródeł informacji – zostawienie polubień na fanpage’ach, które nie do końca odpowiadają naszym poglądom, zaglądanie na portale „sprzyjające przeciwnemu obozowi”.

- Jeśli ktoś został usunięty z grona naszych znajomych na Facebooku ze względu na odmienne poglądy, zaprośmy go ponownie – będziemy mogli z nim konfrontować swoje myśli.

- W internecie można znaleźć agregatory treści, które zbierają wiadomości z portali reprezentujących wiele poglądów – pozwala to na dostrzeżenie różnic w opiniowaniu sytuacji przez ludzi o odmiennych poglądach. Może to być Squid, Upday czy Flipboard.

- Kiedy natkniemy się na wiadomość, sprawdźmy, jak jest przedstawiona na innych portalach. Wtedy nie uda się nam zapomnieć, że nie istnieje tylko jedna racja.